ARTICULO

RESUMEN RESULTADOS DISCUSION

Para investigar los efectos de la complejidad de una tarea de localización de fallos sobre la carga percibida por los sujetos y sobre la ejecución, se diseñó un experimento en el que se combinaban los siguientes factores entresujetos: número de componentes del sistema (complejidad perceptiva) y extensión de la pista proporcionada para resolver el problema (complejidad de solución del problema). La tarea consistía en localizar el componente del sistema que no actuaba correctamente. Se utilizaron los operadores lógicos Y, 0 e inversor para representar la función de cada componente. Cada uno de los elementos del sistema contenía información en forma de símbolos. Para medir la carga subjetiva se utilizó un instrumento similar al TLX (Task Load Index).

Los resultados sugieren una disociación entre las medidas subjetivas de carga y la ejecución. El efecto facilitador de las pistas proporcionadas se puso de manifiesto reduciendo el tiempo total de ejecución y el número de componentes revisados. El aumento de la complejidad perceptiva incrementó el número de componentes revisados por los sujetos. Además, los resultados indicaron que el éxito en la ejecución está determinado en gran medida por el uso de estrategias de búsqueda de información apropiadas.

An experiment was conducted to investigate the effects of task complexity and cues on subjective workload response and performance using a fault location task. There were two between-subject factors: number of system elements (perceptual complexity) and cue extension (problem solving complexity). During the task the subjects tried to detect which one of the functional network components did not work properly. Three logic gates AND, OR and INVERSOR were used to represent the component function. Each one of the system elements included information in terms of symbols. Some subjects recived cues about the type and/or function of the component in which the failure was located. An instrument similar to TLX (Task Load Index) was used to assess subject's mental workload.

The results suggest a dissociation between subjective workload measures and performance. The cue extension increment reduced performance time and number of test needed for problem solution. Perceptual complexity increased number of test needed. Performance success was largely determined by adopting an appropriate search heuristic.

Diagnóstico, carga mental subjetiva, complejidad, estrategias.

Diagnosis, Subjective mental workload, Task complexity, Search heuristics.

En la actualidad, es cada vez más importante, para los diseñadores de puestos de trabajo y para los operarios, estudiar la carga mental que entrañan cada una de las tareas a realizar (Hancock y Meshkati, 1988). El concepto de carga mental ha sido definido como la diferencia entre las demandas de una tarea y la capacidad del individuo. De esta forma, se habla de situaciones de infracarga cuando la capacidad del individuo es muy superior a la que la tarea le demanda, o de situaciones de sobrecarga en el caso en el que la tarea demanda más capacidad de la que el sujeto posee. En el primer caso se pueden producir problemas de apatía, mientras que las situaciones de sobrecarga pueden dar lugar a accidentes y errores humanos que pueden implicar graves consecuencias, si bien ambas situaciones pueden ser origen de insatisfacción laboral.

Las situaciones de sobrecarga son cada vez más frecuentes en el mundo laboral, el cual debe incorporar los adelantos tecnológicos para obtener mayor producción a menores costos. Así, son cada vez más frecuentes las tareas de vigilancia y solución de problemas, en las que el operador debe considerar múltiples fuentes de información a la hora de realizar su trabajo. Dada la complejidad y necesidad de estas tareas, se hace imprescindible el estudio de la carga mental que entrañan, con el fin de evitar, desde la fase de diseño, los problemas que se puedan derivar de una situación de sobrecarga (Gopher y Donchin. 1986; O'Donnel y Eggemier, 1986).

De todos los procedimientos de evaluación de la carga mental que se han distinguido, son las técnicas subjetivas junto con las medidas de ejecución, las que han sido objeto de un uso mayoritario (Moray, 1982). Fundamentalmente, dos han sido las razones de este uso casi generalizado de las técnicas subjetivas de medida de la carga mental: 1) Su facilidad de uso y gran aceptación por los operadores, y 2) Su finalidad: evaluar la carga percibida por los operadores.

Por otro lado, multitud de trabajos avalan la validez de las técnicas subjetivas, entendida como la capacidad de la técnica para distinguir entre diversos niveles de dificultad de la tarea (Bortolussi y col. 1986; Hancock, 1989; Nygren, 1991; Vidulich y col., 1991). Sin embargo, otros autores han obtenido resultados contrarios a los anteriores (Vidulich y Tsang, 1986; Vidulich y Wickens, 1986; Derrick, 1988), y han mostrado la existencia de disociaciones o desacuerdos entre las medidas subjetivas y las de la ejecución.

En relación al diagnóstico de fallos, en uno de sus trabajos más clásicos Rouse y Rouse (1979) estudiaron la complejidad de diversas tareas de diagnóstico y solución de problemas, y su efecto sobre la ejecución. Ellos distinguieron entre complejidad perceptiva y complejidad cognitiva o de solución del problema. La primera hace referencia a la habilidad para reconocer y manipular patrones perceptivos. La segunda se relaciona con la capacidad para comprender la estructura del problema o las interrelaciones existentes entre sus elementos, más que con la forma en que se muestra al sujeto. Por tanto, el formato del problema influye en la complejidad perceptiva, la cual afecta, a su vez, a la complejidad global de la tarea, pero no es una característica particular del problema en sí mismo.

En su estudio, Rouse y Rouse (1979) aplicaron cuatro métricas de la complejidad del problema a tareas de detección de fallos. Estas métricas fueron: número de componentes del sistema, número de pruebas necesitadas para alcanzar la solución óptima del problema, número de relaciones relevantes entre los componentes, y una métrica de la teoría de la información. Estas métricas fueron evaluadas en relación al tiempo de tarea como medida global de la ejecución. Las primera y segunda métricas resultaron ser pobres predictores del tiempo de ejecución de la tarea. Sin embargo, la tercera y la cuarta fueron buenos predictores de la medida global de ejecución. Los propios autores señalan que la complejidad perceptiva no fue manipulada sistemáticamente, por lo que no pudieron obtener conclusiones al respecto. Por otro lado, el uso del tiempo de ejecución de la tarea como una medida global de la ejecución parece ser cuestionable, siendo más adecuado utilizar medidas de la eficacia del diagnóstico y del grado de relevancia de la información recogida, así como de las estrategias seguidas por los sujetos en el proceso de solución del problema (Brooke y Duncan, 1981).

La importancia del uso de estrategias sobre la búsqueda y utilización de la información relevante para solucionar el problema ha sido puesta de manifiesto en numerosos estudios (Damos y Smist, 1983; Coury y Pietras (1989). Por ejemplo, Coury y Pietras (1989) encontraron que la estrategia utilizada por los operadores para obtener información sobre el estado del sistema era la variable con mayor impacto sobre la ejecución, independientemente del tipo de display. Utilizando tareas secundarias, Damos y Smist (1983) encontraron que los sujetos que utilizaban estrategias mixtas (uso de varias estrategias durante la realización de una misma tarea) mostraban una peor ejecución que los que utilizaban estrategias puras (durante la misma tarea se utiliza una sola estrategia). Según Scerbo y Fisk (1990), el éxito en la utilización de procedimientos está determinado en gran medida por la adopción de una estrategia de búsqueda apropiada, hasta tal punto que aunque la documentación esté bien diseñada se producirán niveles de ejecución inferiores al óptimo si los individuos adoptan estrategias inapropiadas.

La relación entre carga mental y estrategias de solución de problemas y adquisición de información se plasma en los trabajos realizados por Rasmussen (1981) o Morris y Rouse (1985), entre otros. En estos trabajos aparece la carga mental como determinante de la adopción de una determinada estrategia. De esta forma, parece que en situaciones de sobrecarga la estrategia se basa en las relaciones topográficas del sistema, mientras que en situaciones de menor carga se suele optar por una estrategia basada en los síntomas del problema.

Por otro lado, la detección y localización de un estímulo se ve facilitada por el conocimiento anterior de alguna de sus propiedades (Posner y col., 1978). Los efectos de la extensión, o grado de información, de«estas pistas o conocimiento anterior, sobre la precisión y la rapidez de la ejecución han sido puestos de manifiesto en multitud de estudios (Bishu y col., 1989). Por tanto, a la luz de estos trabajos, se puede decir que la introducción de pistas acerca de la solución correcta podría hacer disminuir la complejidad cognitiva de la tarea.

En la presente investigación se pretende determinar los efectos de la complejidad perceptiva y cognitiva de una tarea de detección de fallos sobre la ejecución y la carga mental subjetiva.

La muestra estuvo compuesta por 32 sujetos, alumnos de 3. er curso de la facultad de psicología de la U.C.M., de los cuales cinco fueron varones y 27 mujeres. La edad de los participanates estaba comprendida entre los 20 y los 25 años.

El diseño fue un factorial 2 X 4 entresujetos, resultante de la combinación de las variables numero de unidades - componentes del sistema( 16 unidades/20 unidades) y extensión de la pista proporcionada al sujeto (Sin pista /solo forma/ sólo color /color y forma). El número de componentes del sistema determino la complejidad perceptivas de la tarea, mientras que la extensión de la pista sería la variable responsable de las variaciones en la complejidad cognitiva o de solución.

Como variables dependientes se utilizaron el número de aciertos, el tiempo utilizado para la realización de la tarea, el número de elementos del sistema analizados por el sujeto hasta alcanzar la solución y un índice de la carga mental percibida por los sujetos. Asimismo, se recogieron los caminos o recorridos seguidos por los participantes para la obtención de información, los tiempos de inspección de cada uno de los componentes del sistema y el número de veces que el sujeto había observado cada unidad o componente, como medio para determinar las estrategias generales utilizadas por los sujetos para resolver el problema.

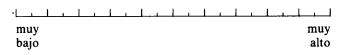

El nivel de carga percibido por los sujetos fue medido mediante un índice similar al TLX (Nasa Task Load Index) (para una descripción de este instrumento ver Hart y Staveland, 1988). Se distinguieron siete dimensiones de carga- esfuerzo, demanda cognitiva, demanda perceptiva, demanda física, demanda temporal, ejecución o rendimiento y nivel de frustración (ver apéndices 1 y 2 para la descripción de estas dimensiones).

Básicamente, la aplicación de este instrumento requiere dos fases, una de las cuales es anterior al experimento y la otra se completa inmediatamente después de que éste haya terminado. En la primera fase los sujetos comparan cada una de las dimensiones con las restantes, a modo de comparaciones binarias, estableciendo cuál de las dimensiones de cada par es percibida como una fuente mayor de carga. Los sujetos tienen la definición de cada una de las dimensiones frente a ellos durante las 21 comparaciones. Posteriormente, se obtiene un peso, para cada una de las dimensiones, en función del número de veces que la dimensión ha sido elegida. Estos pesos pueden tomar valores entre cero (esta dimensión no ha sido ninguna vez elegida como mayor fuente de carga) y seis (la dimensión ha sido elegida en todos los pares en los que aparece). En la segunda fase (una vez realizado el experimento), los sujetos valoran la tarea que acaban de realizar en cada una de las dimensiones marcando un punto en una escala de 1 a 100 (dividida en intervalos de 5 unidades) (ver apéndice 2).

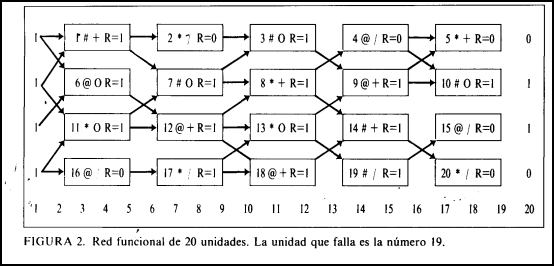

El display utilizado (ver figuras 1 y 2) en el experimento mostraba un sistema formado por 16 (ó 20) componentes, los cuales estaban conectados entre sí de forma que cada componente sólo recibía información de uno (si su función era inversora) o de dos componentes (para las demás). Cada unidad componente contenía 4 informaciones distintas. En primer lugar aparecía el número de identificación, el cual variaba de 1 a 16 (ó 20). A continuación, aparecía el tipo de componente, presentado por medio de tres símbolos diferentes:

*: Sistema de Refrigeración.

#: Reactor.

@: Sistema Eléctrico.

En tercer lugar, aparecía la función del componente, la cual estaba determinada por un operador lógico (Y, 0, o Inversor). La función de la unidad venía expresada por los símbolos siguientes:

+: Operador Y.

0: Operador 0.

/: Operador Inversor.

El operador de tipo Y actúa sobre la información de entrada dando como resultado el menor de los dos valores de dichas entradas (I Y 1 da 1; 1 Y 0 da 0; 0 Y 1 da 0; 0 Y 0 da 0). El operador de tipo 0 evalúa las entradas dando como resultado 1 siempre que alguno de los valores de entrada sea 1, y 0 cuando ambas entradas son 0 (1 ó 1 da 1; 1 ó 0 da 1; 0 ó 1 da 1; 0 ó 0 da 0). El inversor solamente puede tener una entrada y actúa sobre ella dando como resultado el valor contrario a dicha entrada (I inversor da 0; 0 inversor da l).

Por último, aparecía el valor resultado del componente. Esta información podía ser R = 1 o R = 0, dependiendo de los valores de entrada y del operador lógico implicado. Los valores resultado servían a su vez como valores de entrada de los componentes que conectaban con él (situados siempre más a la derecha, ya que la información fluía de izquierda a derecha).

La información que contenían los elementos del sistema estaba siempre oculta, de manera que para poder examinar un determinado componente, el sujeto debía situar el cursor en él. Esta característica hizo posible la recogida de datos sobre tiempos de inspección de los distintos elementos, caminos de búsqueda de información, etc., más precisos, ya que mientras el sujeto observaba un determinado componente del sistema el contenido de los demás estaba oculto, eliminándose las posibles interferencias producidas por el procesamiento de la información de dos elementos a la vez.

El contenido de cada uno de los componentes del sistema y las conexiones entre ellos era constante a lo largo de los 14 ensayos (4 ejemplos y 10 experimentales), variando únicamente el resultado del componente que fallaba y el de aquellos que se veían afectados por este fallo. Se presentó aproximadamente el mismo número de cada tipo de símbolo, repartidos y combinados aleatoriamente.

A la izquierda de la pantalla aparecían los valores de entrada del sistema (siempre eran l). A la derecha de la pantalla aparecían los resultados que debería dar el sistema si todos sus elementos funcionasen correctamente (siempre eran los mismos valores).

La tarea del sujeto consistía en localizar cuál de los 16 ó 20 componentes del sistema no funcionaba como debería. Una vez que el sujeto había encontrado la respuesta debía indicar el número de identificación del componente que fallaba y pulsar cualquier botón del ratón para poder pasar a la siguiente pantalla.

Como ayuda en la búsqueda de la solución, antes de comenzar cada ensayo, el experimentador mostraba, a los sujetos que por el diseño experimental debían recibir algún tipo de pista, una figura coloreada. Esta figura servía como pista. El color podía ser rojo, negro o blanco y hacía referencia al tipo de problema, de forma que:

La forma geométrica podía ser triángulo, círculo o rectángulo, y hacía referencia a la función, de forma que:

En las instrucciones se explicaba detalladamente la forma en la que operan cada uno de los operadores lógicos que aparecían en el experimento. Igualmente se pedía al sujeto que intentara recordar los símbolos utilizados y lo que significaban, aunque el sujeto disponía de un panel, situado de forma que fuera fácilmente visible, en el que se presentaban cada uno de los símbolos y su significado.

Una vez que el sujeto había leído las instrucciones, se realizaban cuatro ensayos de prueba, todos ellos diferentes a los de la fase experimental, en los que el sujeto se familiarizaba con la tarea y con el manejo del ratón; asimismo durante esta fase se resolvían todas las posibles dudas o cuestiones que surgieran. A continuación cada sujeto realizaba las comparaciones de pares entre las siete dimensiones de la escala de carga subjetiva (ver apéndice l). Una vez completadas las 21 comparaciones se pasaba a realizar los diez ensayos de la fase experimental. En el grupo de sujetos que recibieron algún tipo de pista, ésta era proporcionada por el experimentador durante el intervalo entre ensayos, con un tiempo suficiente para la codificación y reconocimiento de la pista, de forma que esto no pudiera influir en el momento de inicio del ensayo. Finalizada la fase experimental, el sujeto completaba la escala de carga subjetiva valorando separadamente cada una de las siete dimensiones (ver apéndice 2).

La tarea fue presentada por un ordenador PC/XT con disco duro y generada y controlada por el programa Mouselab System versión 4.2 (Johnson, Payne, Schkade y Bettman, 1989), el cual también recogió los datos necesarios (tiempos de inspección, secuencias, respuestas, etc.). Dicho programa está especialmente diseñado para ser utilizado con ratón, por lo cual fue imprescindible el uso de un ratón GM-6 PC Mouse.

Se calcularon los pesos de cada una de las siete dimensiones en función del número de veces que cada dimensión había sido elegida en las comparaciones binarias. Estos pesos fueron multiplicados por la valoración que habían dado los sujetos en cada una de las dimensiones una vez realizados los ensayos experimentales, obteniéndose las puntuaciones ponderadas de carga para cada dimensión. El índice de carga global fue calculado como la suma de las puntuaciones ponderadas dividida por 21 (número de comparaciones binarias). Para una descripción detallada de este procedimiento ver Hart y col. (1984).

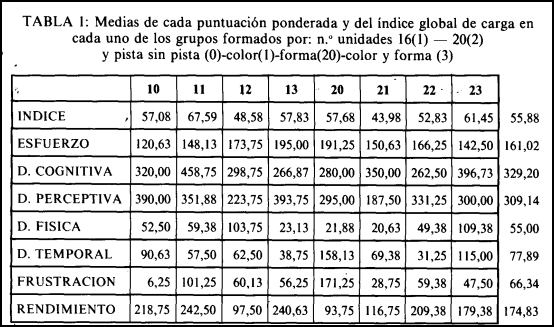

Para cada una de las puntuaciones ponderadas y para el índice global de carga se realizó un ANOVA de dos factores, número de unidades (2 niveles) y extensión de la pista (4), no encontrándose ningún efecto significativo de dichos factores ni de la interacción entre ambos. Este resultado, contrario al obtenido por otros autores (Casali y Wierwille, 1984; Bortolussi y col., 1986; Hancock, 1989) puede deberse a que, en este experimento, ambos factores fueran entre sujetos, mientras que en los trabajos citados anteriormente los factores de complejidad de la tarea fueron de medidas repetidas. La tabla 1 muestra las medias de cada una de estas variables dependientes para cada uno de los ocho grupos.

A partir de la tabla 1 se observa que la dimensión más importante para los sujetos fue la demanda cognitiva, seguida de la demanda perceptiva, el rendimiento y el esfuerzo, siendo mucho menos importantes la demanda temporal, el nivel de frustración y, por último, la demanda física. En general, estos resultados son los esperados, sin embargo, hay que resaltar cómo los sujetos perciben demanda temporal aunque, en realidad, ésta no fuera una característica de la tarea (no había tiempo límite para realizar la tarea); incluso le conceden mayor importancia que a otras variables como la demanda física, la cual aunque en pequeña medida sí estaba presente en la tarea (p.e. movimientos del ratón).

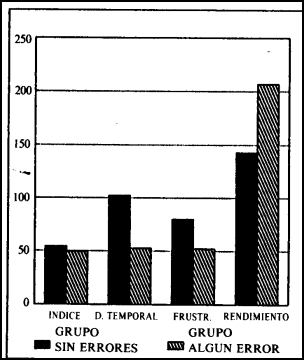

Para comprobar si existían diferencias entre las medias de las variables índice, esfuerzo, dem. cognitiva, dem. física, dem. perceptiva, dem. temporal, frustración y rendimiento, en función del número de aciertos/ errores, se distinguieron dos grupos de sujetos: aquéllos cuya ejecución había sido perfecta (ningún error) y aquéllos que habían cometido al menos un error. Se realizaron pruebas de t entre estos dos grupos obteniéndose los siguientes resultados: no se encontraron diferencias entre las medias de las variables esfuerzo, dem. cognitiva, dem. física y dem. perceptiva. Sin embargo, como muestra la figura 3 se encontraron diferencias significativas en el índice global de carga (p = .019) y en las puntuaciones ponderadas de demanda temporal (p = .024), frustración (p = .016), y rendimiento (p = .040).

Se observa fácilmente que el grupo de personas cuya ejecución es perfecta perciben la tarea como menos demandante, su nivel de frustración es menor y su rendimiento aumenta con respecto al otro grupo.

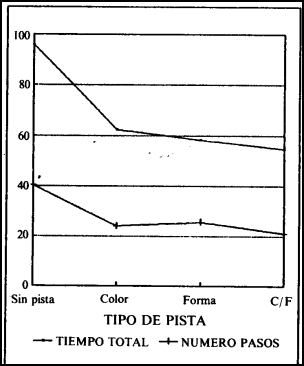

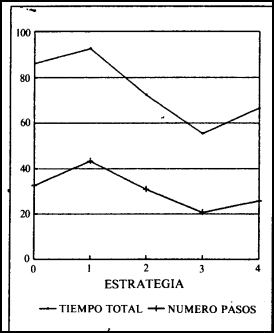

Se realizó un MANOVA de tres factores, número de componentes (2 niveles), extensión de la pista (4 niveles) y ensayo (10), como factor de medidas repetidas, tomando como variables dependientes el tiempo total de ejecución y el número de pasos o elementos del sistema revisados por el sujeto hasta llegar a la respuesta. Se observaron efectos significativos del tipo de pista para las dos variables dependientes (F(3,24) = 9,40, para el tiempo total, y F(3,24) = 18,34, para el número de elementos analizados, con p <.001 en ambos casos). El número de unidades del sistema resultó significativo para la variable número de pasos (F(1,24) = 9.47, p <.006). La interacción entre ambos factores fue significativa para las dos variables dependientes F(3,24) =4.06, para el tiempo total, y F(3,24) = 4.6 1, para el número de pasos, con p < .02 en ambos casos). Como era de esperar, el efecto intrasujeto del ensayo resultó en ambos casos altamente significativo (p < .001), así como la interacción número de elementos X ensayo (p < .01). La figura 4 muestra la reducción en el tiempo total de tarea y en el número de pasos o pruebas necesitadas para dar la solución, que se observa al aumentar la extensión o nivel informativo de la pista.

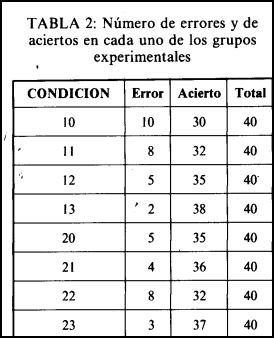

En relación a los aciertos como medida de la ejecución, se realizaron análisis descriptivos comparando el número de aciertos de los diversos grupos formados por la combinación de los factores experimentales. La tabla 2 muestra el número de aciertos y el número de fallos de estos grupos. Se calculó el estadístico lambda de Goodman y Kruskal para analizar la asociación entre dichas variables. Los valores de este estadístico en cada caso mostraron la no asociación entre los factores experimentales y su interacción con la variable de la ejecución acierto/fallo (lambda = 0.02439, para el número de elementos del sistema; lambda = 0.03509, para el tipo de pista proporcionada; y lambda = 0.02462, para la interacción entre ambos factores).

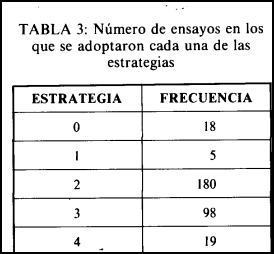

Por otro lado, a partir del camino general seguido por el sujeto en la búsqueda de información, se codificaron los cinco tipos de estrategias siguientes para cada uno de los ensayos:

La tabla 3 muestra la frecuencia de ensayos en los que se utilizaron cada una de las estrategias anteriores.

Para comprobar los efectos de la estrategia utilizada sobre el nivel de ejecución alcanzado por los sujetos, se realizó un análisis de varianza utilizando como variables dependientes el tiempo total de ejecución y el número de pasos necesitados para alcanzar la solución. En este análisis resultó significativo el efecto de la estrategia sobre ambas variables dependientes (F(4,315) = 3.15, p < .02, para el tiempo total, y F(4,315) = 5.36, p < .001 para el número de pasos).

Con el fin de determinar si se podía predecir el éxito o el fracaso en la ejecución, se realizó un análisis de regresión logística según el método Forward Stepwise (LR). Se utilizaron como variables predictoras del éxito' en la realización de la tarea el tiempo total de ejecución, la estrategia seguida, y el número de elementos analizados por el sujeto antes de dar la respuesta. Las variables predictoras que entraron en la ecuación definitiva fueron la estrategia (Wald = 30.68, p < 0.0001), y el número de pasos (Wald = 11.98, p < 0.00 l), con un porcentaje total de casos correctamente clasificados del 88.75%.

En general, y en contra de lo obtenido por autores como Bortolussi y col. (1986), Hancock (1989), Nygren (1991) o Vidulich y col. (1991), los resultados obtenidos en este estudio acerca de la medida de la carga subjetiva no muestran los efectos de las variaciones en la complejidad de la tarea sobre las puntuaciones de carga mental subjetiva, obtenidas a partir de un instrumento muy similar al TLX (Nasa Task Load Index). Este resultado podría deberse a varias razones:

1. En primer lugar, y como ya se ha mencionado, autores como Poulton (1982) han estudiado el comportamiento diferencial de las variables en función del tipo de diseño experimental que se establezca. Así, parece que los resultados de un mismo experimento pueden ser distintos según se trate de variables de medidas repetidas o entresujetos.

2. En segundo lugar, la técnica puede no ser sensible a las variaciones en la complejidad de la tarea, lo cual estaría en contra de los resultados obtenidos por Vidulich y Tsang (1986). Quizá, la falta de sensibilidad de la técnica podría proceder del excesivo número de dimensiones de carga mental subjetiva que contempla (Reid y col., 1982). Este gran número de dimensiones a evaluar puede producir confusión en los sujetos que se traduce en la no sensibilidad. Por ejemplo, parece que los sujetos no fueron capaces de evaluar todas las demandas de la tarea adecuadamente; dieron más importancia a la demanda temporal que a la física, cuando en realidad no existió tiempo límite para realizar la tarea. Sin embargo, se encontraron variaciones en el nivel global de carga percibida, así como en las dimensiones de demanda temporal, frustración, y rendimiento, en función del grado de éxito en la realización de la tarea de localización de fallos utilizada. En este sentido los sujetos que dieron la respuesta correcta en todos los ensayos percibieron la tarea como menos demandante, su nivel de frustración fue menor y su nivel de rendimiento percibido aumentó con respecto al grupo de sujetos que cometieron al menos un error en su diagnóstico. Por tanto, parece que la técnica mostró algún tipo de sensibilidad ya que fue capaz de establecer diferentes puntuaciones de carga mental subjetiva para distintos grupos de sujetos.

3. Por último, la falta de efectos significativos de la complejidad sobre la carga mental subjetiva podría deberse a que la tarea no reflejara realmente diferencias en la complejidad. Sin embargo, esta última posibilidad puede ser descartada ya que se encontraron efectos de la complejidad sobre la ejecución. Por lo tanto, la última posibilidad sería la existencia de disociaciones entre las medidas de carga mental subjetiva y las de la ejecución en la tarea (Vidulich y Wickens 1986; Derrick 1988).

En cuanto a la ejecución, el aumento de la complejidad perceptiva produjo un incremento en el número de componentes del sistema analizados por los sujetos para alcanzar la solución, sin embargo el tiempo de ejecución no se vio modificado por las variaciones de la complejidad perceptiva. Estos resultados parecen indicar que, bajo condiciones de una mayor complejidad perceptiva, los sujetos tienden a observar un mayor número de unidades de información pero dedican menos tiempo al análisis de cada una de ellas.

Por otro lado, el incremento de la complejidad de solución del problema, establecida por las variaciones de la extensión, o grado de información, de la pista proporcionada a los sujetos acerca del elemento del sistema en el que se estaba produciendo el fallo, determinó el aumento del tiempo total requerido por los sujetos para realizar la tarea, así como del número de elementos del sistema analizados por el sujeto para establecer un diagnóstico. Esto indica, como se había previsto, que el conocimiento anterior de alguna de las características del estímulo que se está buscando facilita enormemente su localización (Posner y col., 1978; Bishu y col., 1989; Jubis, 1990), sobre todo en términos del tiempo de ejecución (ver figura 4). La figura 4 muestra la gran diferencia existente en tiempo de ejecución y en el número de elementos del sistema observados que existe entre el grupo de sujetos que no recibieron ninguna pista y el grupo de sujetos que recibieron información anterior sobre el tipo de problema y/o sobre la función del componente que fallaba. Las diferencias entre los dos grupos que sólo recibieron una de las dos informaciones, tipo de problema o función, fue muy pequeña, de manera que ambas pistas resultaron ser igualmente facilitadoras de la ejecución. Estos resultados ponen de manifiesto la gran importancia del poder informativo de los sistemas de alarma y de las ayudas a la decisión, así como la necesidad de diseñar estos sistemas de forma que sean lo más informativos posibles para el operador (Lind, 1991; Reason, 1991).

La influencia sobre el nivel de ejecución alcanzado por los sujetos de las estrategias de búsqueda de información, establecidas en función de los caminos o patrones de búsqueda seguidos por los sujetos, se puso de manifiesto en varios análisis. En primer lugar, las medidas globales de la ejecución (tiempo total de tarea y número de elementos del sistema analizados) se vieron afectadas por la estrategia de búsqueda de información utilizada por los sujetos. Por otro lado, la influencia de la estrategia utilizada sobre el éxito de la ejecución fue puesta de manifiesto en el análisis de regresión logista realizado, en el cual resultó ser (junto con el número de elementos analizados) un buen predictor del acierto, y por tanto también del error, en la respuesta. Parece que la estrategia más eficaz fue la codificada como 3, mientras que la menos efectiva fue la 1 (ver figura 5). La diferencia entre ambas estrategias de búsqueda de información radica en que mientras que la 1 implica la comparación de los resultados que el sistema debería dar con los reales, la 3 parte de los valores de entrada al sistema. Por tanto, siguiendo la distinción establecida por Rasmussen (1981) se podría decir que la estrategia 1 sería de alguna forma guiada por los síntomas (estrategia sintomática), ya que implica el análisis de los resultados del sistema, mientras que la estrategia 3 estaría guiada más por los aspectos físicos del sistema (estrategia topográfica). Los trabajos realizados por Rasmussen (1981) y por Rouse y Rouse (1984) han puesto de manifiesto como el aumento en la dificultad de la tarea, y por tanto en el esfuerzo o carga mental, provoca un cambio en la estrategia de búsqueda de información seguida por los operadores. Así, y con el fin de reducir los niveles de carga mental que genera la tarea, a medida que la carga es mayor los operadores tienden a utilizar una estrategia topográfica en lugar de sintomática, quedando esta última reservada para las situaciones de menor carga. Por lo tanto, en consonancia con los trabajos mencionados, y ya que se trataba de una tarea difícil para los sujetos los cuales no estaban familiarizados con este tipo de tareas (se trataba de estudiantes de Psicología), la estrategia más eficaz resultó ser la topográfica, puesto que permitió a los sujetos que optaron por ella una reducción considerable de los niveles de carga.

En conclusión, y como se esperaba en función de los resultados obtenidos por otros investigadores (Vidulich y Wickens, 1986; Derrick, 1988), la medida de carga subjetiva utilizada no parece ser sensible a los efectos de la manipulación de la complejidad de tareas de detección o localización de fallos del tipo utilizado en este experimento, pareciendo, en principio, más adecuadas las medidas de la ejecución. Mientras que las variaciones de la complejidad de la tarea se pusieron claramente de manifiesto en la ejecución, no hubo diferencias en los niveles de carga percibida. Cabe destacar que posiblemente este hecho se deba al tipo de diseño utilizado. Parece ser que en otras investigaciones en las que la variable de complejidad de la tarea se introducía como factor intrasujeto, su efecto sí fue percibido por los sujetos (Hancock, 1989; Bortolussi y col., 1986). Por tanto, sería conveniente estudiar la validez del instrumento en condiciones en las que la complejidad fuera manipulada intrasujetos, además de comprobar si el instrumento es capaz de captar diferencias en la complejidad de la tarea cuando el número de dimensiones de carga mental subjetiva se reduce.

Finalmente, cabe destacar el efecto facilitador del conocimiento anterior de alguna de las características de la respuesta correcta sobre la ejecución en tareas de localización de fallos como la que se utilizó en este experimento (Bishu y col., 1989; Jubis, 1990), lo cual revela la necesidad de diseñar sistemas de ayuda a la decisión que informen lo más posible al operador del tipo de problema y del lugar en el que se está produciendo. Asimismo, y como apoyo a los resultados encontrados por autores como Coury y Pietras (1989) o Scerbo y Fisk (1990), la estrategia de búsqueda de información utilizada por los sujetos resultó ser determinante del éxito y de la rapidez de la ejecución.

DEFINICION DE LAS DIMENSIONES 1.- ESFUERZO:

¿Qué nivel de esfuerzo mental y físico has tenido que invertir para alcanzar tu nivel de ejecución en la tarea?

2.- DEMANDA COGNITIVA:

Nivel de actividad mental que requiere la tarea (recordar, decidir, memorizar, calcular, etc.). ¿Se trata de una tarea fácil o difícil, simple o compleja, exigente o relajada?

3.- DEMANDA PERCEPTIVA:

Nivel de actividad perceptiva que requiere la tarea (mirar, buscar, distinguir, etc.). ¿Se trata de una tarea fácil o difícil, simple o compleja, exigente o relajada, respecto a esta dimensión?

4.- DEMANDA FISICA:

Nivel de actividad física que requiere la tarea (tirar, empujar, pulsar, mover, girar, deslizar, etc.). ¿Se trata de una tarea fácil o difícil, aburrida o amena, demasiado lenta o muy rápida, descansada o laboriosa?

5.- DEMANDA TEMPORAL:

Presión temporal sentida debida al tiempo disponible para realizar cada ensayo de la tarea. ¿Es mucho tiempo, poco, suficiente?

6.- EJECUCION 0 RENDIMIENTO:

¿Cuán exitosa crees que ha sido tu ejecución, en el sentido de alcanzar los objetivos o metas establecidas por el investigador (o por ti mismo)? ¿Estás satisfecho/a con tu nivel de ejecución o rendimiento?

7.- NIVEL DE FRUSTRACION:

¿En qué medida te has sentido inseguro/a, desalentado/a, estresado/a o molesto/a, durante la tarea?

A B

DEFINICION DE LAS DIMENSIONES

1- ESFUERZO:

¿Qué nivel de esfuerzo mental y físico has tenido que invertir para alcanzar tu nivel de ejecución en la tarea?

2.- DEMANDA COGNITIVA:

Nivel de actividad mental que requiere la tarea (recordar, decidir, memorizar, calcular, etc.). ¿Se trata de una tarea fácil o difícil, simple o compleja, exigente o relajada?

3.- DEMANDA PERCEPTIVA:

Nivel de actividad perceptiva que requiere la tarea (mirar, buscar, distinguir, etc.). ¿Se trata de una tarea fácil o difícil, simple o compleja, exigente o relajada, respecto a esta dimensión?

4.- DEMANDA FISICA:

Nivel de actividad física que requiere la tarea (tirar, empujar, pulsar, mover, girar, deslizar, etc.). ¿Se trata de una tarea fácil o difícil, aburrida o amena, demasiado lenta o muy rápida, descansada o laboriosa?

5.- DEMANDA TEMPORAL:

Presión temporal sentida debida al tiempo disponible para realizar cada ensayo de la tarea. ¿Es mucho tiempo, poco, suficiente?

6.- EJECUCION 0 RENDIMIENTO:

¿Cuán exitosa crees que ha sido tu ejecución, en el sentido de alcanzar los objetivos o metas establecidas por el investigador (o por ti mismo)? ¿Estás satisfecho/ a con tu nivel de ejecución o rendimiento?

7 - NIVEL DE FRUSTRACION:

¿En qué medida te has sentido inseguro/a, desalentado/a, estresado/a o molesto/a, durante la tarea?

ESFUERZO

DEM. COGNITIVA

DEM. PERCEPTIVA

DEMANDA FISICA

DEM. TEMPORAL

EJECUCION

FRUSTRACION