ARTICULO

RESUMEN

- Criterios de evaluación

- Evaluación y medida

- Desarrollo de las técnicas de medida seleccionadas

- Aplicación de los diseños de evaluación

- Análisis de la validez de los res tados de la evaluación

- Planteamiento de la Investigación

METODOLOGIA RESULTADOS CONCLUSIONES

En el artículo se analiza, en primer lugar, cuáles son, según Kirkpatrick (1987), los criterios de evaluación de un programa de formación. Uno de estos criterios es la valoración del programa. Y, en segundo lugar, se presenta un ejemplo de un procedimiento para la valoración de cursos en formación.

In this article, first, Kirkpatrick's evaluation levels of a training program is analyzed. Valoration is one of these training program evaluation levels. Second, an example of a procedure for training courses valuation is proposed.

Valoración, Evaluación, Cursos de Formación.

Evaluation, Assessment, Training courses.

Cuando se trata de definir qué es evaluación, varios autores coinciden en señalar la complejidad del término (Pe: Fernández Ballesteros, 1982; Kirkpatrick, 1987; Laird, 1985; Goldstein, 1986). Semánticamente se ha distinguido entre los términos evaluación y valoración. Así, el término evaluación, tal como lo define Fernández Ballesteros (1982, p. 35) « ... su. pone el análisis de una serie de variables conductuales y ambientales relevantes en un momento dado, en un sujeto o en un grupo de sujetos», mientras que el término valoración « ... implica la estimación del valor de un determinado tratamiento, programa o intervención que se ha aplicado en un contexto a un sujeto o un grupo de sujetos específicos». Para la autora, sin embargo, estas diferencias semánticas serían convencionales, pues, como afirma, « ... en toda evaluación conductual, existe un momento de valoración y, a su vez, toda valoración de programas supone, al menos, dos momentos evaluativos».

En definitiva, la evaluación « ... supone un proceso mediante el que se trata de estimar, a través de una metodología empírica, si se han alcanzado una serie de objetivos socialmente relevantes» (Fernández Ballesteros, 1982, p. 37).

Cuando se aplican estos conceptos al campo de la formación, la definición dada por Goldstein (1986) de evaluación de la formación nos abre camino para tratar un problema común que se viene planteando en este ámbito y que trataremos posteriormente. Así, para Goldstein la evaluación sería: « ... la colección sistemática de información descriptiva y de juicio necesaria para tomar decisiones eficaces de la formación relacionadas con la selección, adopción, valoración y modificación de distintas actividades de la instrucción. Los objetivos de los programas de instrucción reflejan numerosas metas que van desde el progreso del individuo hasta las metas de la organización. Desde esta perspectiva, la evaluación es una técnica de obtención de información que posiblemente nos puede dar como resultado decisiones que categoricen los programas como buenos o malos. Más aún: la evaluación capturaría la esencia dinámica del programa de formación. Posteriormente, estará disponible la información necesaria para revisar los programas de instrucción para lograr los múltiples objetivos de la instrucción» (p. 237).

Si la evaluación es la determinación de la eficacia de un programa de formación, la cuestión que se plantea entonces es determinar la eficacia en función de qué. Para Kirkpatrick, la evaluación incluiría cuatro categorías de medida: las reacciones de los individuos, el aprendizaje, la conducta y los resultados. Evaluar la reacción de los individuos a un programa de formación sería analizar si el programa les ha gustado o no. En la mayoría de los casos, la evaluación de la reacción se lleva a cabo mediante un cuestionario desarrollado para ello, y en el que los sujetos dan la información pertinente en un tiempo relativamente corto. Evaluar la reacción de los sujetos implica conocer hasta qué punto hemos logrado transmitir un material y unos conocimientos de una manera amena e interesante para los participantes. Si se logra motivar a los individuos durante el proceso de formación, se logra con ello crear unas actitudes favorables que faciliten la adquisición de conocimientos.

En segundo lugar, la evaluación de la eficacia de un programa de formación requiere analizar el grado en que los conocimientos impartidos han sido realmente adquiridos por los individuos. Como señala Kirkpatrick (1987), una reacción favorable a un programa no asegura el aprendizaje. En términos de evaluación, este autor considera el aprendizaje como un cambio de actitudes, o adquisición de unos conocimientos y destrezas.

En tercer lugar, se lleva a efecto: la evaluación de la conducta. Esto es: el que durante el proceso de formación se haya producido un cambio de actitudes, o una adquisición de destrezas y conocimientos no garantiza que estas actitudes, destrezas y conocimientos sean aplicados por los sujetos en la práctica. Kirkpatrick (1987) considera cinco requisitos indispensables para que tenga lugar un cambio de conducta:

Y, por último, para evaluar la eficacia de un programa de formación necesitamos analizar también los resultados obtenidos. Generalmente, la planificación y desarrollo de la formación van unidos a la consecución de ciertos objetivos. Estos objetivos bien pueden ser un aumento de la calidad de producción, una disminución de las tasas de absentismo, una reducción de los costos de producción, etc. Evaluar la eficacia de un programa, en función de los resultados, implica analizar si se han cumplido los objetivos para los cuales tuvo lugar el proceso de formación.

El modelo de evaluación de la formación de Kirkpatrick contiene tres supuestos implícitos. En primer lugar, la evaluación de cada uno de los cuatro criterios proporciona información en orden ascendente; la evaluación de la conducta proporciona mayor información que la evaluación de la adquisición de conocimientos. En segundo lugar, estas cuatro fases de evaluación están relacionadas causalmente; de esta manera, un cambio de conducta sólo es posible en la medida en que se haya producido una adquisición de conocimientos. Y, en tercer lugar, se supone implícitamente que las intercorrelaciones entre las distintas fases de evaluación son positivas.

Estos supuestos han sido revisados y examinados detenidamente por Alliger y Janak (1989). Tras una exhaustiva revisión de la literatura, estos autores cuestionan el cumplimiento de tales supuestos. No obstante, consideran que el modelo de Kirkpatrick, uno de los primeros modelos creados para evaluación de la formación, sigue teniendo valor y vigencia; es así que la mayoría de los modelos de evaluación de la formación creados posteriormente se basan en los mismos criterios que el modelo de Kirkpatrick.

Otro aspecto importante que señalan Alliger y Jank (1989), en su revisión bibliográfica, es el divorcio entre la teoría y la práctica, cuando se trata de evaluar cursos de formación. En la práctica, la mayoría de las veces sólo se evalúa la valoración de los sujetos a los cursos de formación.

Cuando se habla de evaluación de la formación es corriente tomar como sinónimos evaluación y medida. Sin embargo, a efectos teóricos y prácticos es necesario distinguir ambos términos. La medida sería el proceso de obtención de datos, mientras que la evaluación sería el proceso de análisis e interpretación de esos datos (Laird, 1985).

Según Laird (1985), si el objetivo es establecer juicios fiables sobre unos datos es necesario entonces obtener datos cuantitativos. En este sentido, medir sería asignar números a los procesos, a los sucesos o a los ítems, utilizando para ello un conjunto de reglas consistentes. Sólo cuando la evaluación se base en un proceso cuantitativo de medida conseguiremos:

Bajo este prisma, la evaluación consistiría en hacer juicios sobre los datos recogidos. Sin embargo, no toda evaluación implica medida, pero si una evaluación objetiva.

El proceso de medida incluirá dos fases principalmente:

Con objeto de ilustrar la puesta en práctica de estos modos de operar expondremos la experiencia de un programa de evaluación, desarrollada hace dos años, sobre el análisis de la eficacia del programa MABEM.

El Instituto de la Mujer tuvo la iniciativa de crear en 1988 unos módulos de entrenamiento en búsqueda de empleo dirigidos a la mujer -MABEM- (Aramburu y Fernández, 1988), en respuesta a las necesidades y problemas planteados por un colectivo altamente afectado por el desempleo y el subempleo. Estos módulos estaban formados por tres programas básicos:

Una vez que fueron impartidos los módulos, el objetivo siguiente consistió en evaluar su eficacia (Fernández Garrido, et al. 1990). La evaluación se diseñó según los criterios que propone el modelo de Kirkpatrick: satisfacción de las participantes con el curso o valoración del mismo, conocimientos adquiridos en los módulos, cambio de conducta a la hora de buscar empleo y resultados obtenidos en función de cuántas mujeres lograron hallar empleo.

Posteriormente se crearon las medidas oportunas para efectuar la medida de tales criterios. Estas técnicas fueron de dos tipos: cuantitativas y cualitativas.

Las medidas cuantitativas estaban apoyadas en unos cuestionarios estructurados que facilitaran la evaluación de las diferentes dimensiones. Estos estaban integrados cronológicamente por:

Las medidas cualitativas estuvieron constituidas por las observaciones que las monitoras pudieron recoger y transmitir referentes a los diferentes aspectos a evaluar.

Una vez recogidos los datos cuantitativos se sometieron a los análisis estadísticos pertinentes. Con ello estábamos en condiciones de emitir juicios sobre los datos, es decir, de proceder a la evaluación de los módulos MABEM.

Una vez que ha concluido el proceso de evaluación de un programa de formación es conveniente analizar si los resultados obtenidos son válidos o no.

En este sentido, Goldstein (1986) considera que el análisis de la validez debe dar respuesta a las siguientes preguntas:

Dar respuesta a estas preguntas nos proporcionaría información sobre los distintos tipos de validez de la evaluación:

Dentro del marco de la evaluación de la formación que hemos expuesto, el objetivo de la investigación se centró en el desarrollo del criterio de valoración de la formación. Esto es, en relación a los criterios propuestos por Kirkpatrick (1987), nos planteamos la evaluación de la reacción de los participantes a cursos de formación.

La novedad reside en el procedimiento y en la metodología seguida para evaluar dicho criterio.

En el transcurso de dicha investigación se diseñó y se puso a prueba un procedimiento para estimar la valoración de la formación que cumpliera los siguientes requisitos:

Estos requisitos se fundamentan en las necesidades y exigencias que se plantean en las organizaciones y en la práctica profesional cuando se intenta evaluar la formación.

Los criterios de evaluación que se plantearon fueron los siguientes:

La fase de la aplicación de los objetivos establecidos consistió en intentar acceder a determinados cursos de formación. Con este fin, nos pusimos en contacto con el Colegio Oficial de Psicólogos, el cual nos dio una vía de acceso a los cursos de formación de la V Escuela de Verano, que se celebró en el campus de Somosaguas del 8 al 12 de julio de 1990.

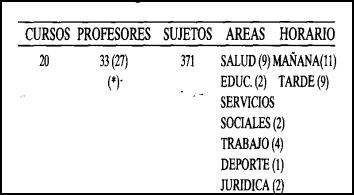

Los cursos en los que se puso a prueba el procedimiento de evaluación desarrollado fueron los siguientes:

El formato del procedimiento de evaluación diseñado para los alumnos se presenta en el Anexo 1. La recogida de información se distribuye en dos grandes apartados: uno cuantitativo y otro cualitativo.

En el primero de ellos se recoge información sobre las características sociodemográficas de los alumnos y una evaluación, sesión a sesión, del Contenido, Metodología utilizada, Compañeros, Formador y Satisfacción general. En la última sesión (quinta) se les pedía a los asistentes, además, que evaluaran globalmente los siguientes criterios: Organización de la escuela, impacto, alcance y difusión de la escuela, Actividades (conferencias, debates ... ), Beneficios aportados, Contenido del curso, Metodología utilizada, Compañeros, Formador y Satisfacción general. En la parte superior de cada hoja de evaluación se registraba el número del curso, el DNI y un código personal para poder identificar la evaluación de las sesiones que pertenecen a cada alumno.

Estos criterios se evaluaron mediante un sólo ítem con una escala de respuesta tipo Likert desde 1 (Muy negativo) a 6 (Muy positivo).

La información cuantitativa se complementó con una evaluación cualitativa en la que los asistentes debían indicar los aspectos que, a su juicio, consideraban positivos y negativos de la Organización, impacto, alcance y difusión de la escuela, Contenido del curso, Formador y Actividades. Por último, debían señalar los beneficios aportados por la asistencia a la V Escuela de Verano.

El cuestionario que se diseñó para los formadores (Anexo 2) consta igualmente de un apartado cuantitativo y otro cualitativo. En la parte cuantitativa se recogen las características sociodemográficas y la valoración global que le merecen los siguientes criterios: Satisfacción con alumnos, Impacto, alcance y difusión de la Escuela, Actividades (conferencias, debates ... ), Organización de la Escuela y Satisfacción general. Estos criterios se evalúan mediante un ítem con una escala de respuesta tipo Likert desde 1 (Muy negativo) a 6 (Muy positivo).

En el apartado cualitativo se recoge, mediante preguntas abiertas, los aspectos positivos y negativos que a juicio del formador le merecen los alumnos; el impacto, alcance y difusión de la escuela; las actividades (conferencias, debates ... ), y la Organización de la Escuela. Por último, se incluye un apartado para comentarios y observaciones.

Los cursos tenían una duración total de quince horas, repartidas en cinco sesiones de tres horas cada una. A los participantes se les pasó la hoja de valoración cuantitativa de cada sesión en la última media hora de la misma. En la sesión final se les pasó, además de la correspondiente a dicha sesión, otra hoja de valoración cuantitativa del total de las sesiones (de igual diseño que las anteriores) y la hoja de valoración cualitativa del total de las sesiones. A los formadores se les pasó las hojas de evaluación cuantitativa y cualitativa únicamente en la última media hora de la última sesión.

En primer lugar se notificó, por carta, a los profesores correspondientes que durante el desarrollo del curso se iban a realizar los procedimientos requeridos para la evaluación.

Para la distribución de los cuestionarios se entrenaron adecuadamente a seis sujetos que actuaron de colaboradores.

La información cuantitativa obtenida se analizó utilizando la media estadística y la moda como índices de tendencia central. Se utilizaron además como índices estadísticos las frecuencias y porcentajes. Estos análisis se efectuaron mediante el programa BMDP 2D. También se analizaron las diferencias significativas entre áreas, cursos y horarios de mañana y tarde a través del programa estadístico BMDP 3S.

La información cualitativa se analizó, en primer lugar, agrupando las respuestas de contenido similar en categorías para cada criterio, y, en segundo lugar, se hallaron los porcentajes de sujetos que consideraban estas categorías aspectos positivos y/a negativos y los porcentajes de respuestas para cada categoría.

Una vez finalizada la interpretación de los resultados obtenidos, la eficacia de la evaluación depende también de la utilidad que tenga para los participantes y formadores el feedback que reciban, Por ello, el diseño de los instrumentos de evaluación incluye además el de los informes de los resultados que se van a presentar. En este caso, el diseño de los informes a emitir debía cumplir los requisitos de presentar de una manera clara y concisa los resultados de la evaluación de los criterios planteados y presentar dichos resultados de una manera fácil de interpretar.

El tipo de informe que se mandó a los formadores muestra los datos obtenidos en forma de gráficas, lo que a nuestro juicio facilita la interpretación de los datos y resulta más fructífero el feedback recibido. El formato de las gráficas es similar al que se expone en el informe de los organizadores. A los formadores se les mandó un total de once paginas, en las que se incluyeron las instrucciones para la interpretación de las gráficas y las siguientes representaciones gráficas: la valoración global de los criterios evaluados, que se recogió el último día; la representación gráfica de las modas obtenidas en cada sesión respecto a los criterios evaluados; la comparación, en forma de gráfica, entre los resultados medios globales obtenidos por ese curso en cada criterio y los obtenidos por el resto de los cursos que pertenecen al mismo área en cada criterio; una tabla con los datos cuantitativos correspondientes a la gráfica anterior; y, por último, una tabla con las categorías de respuestas que surgieron a través del análisis de contenido (ver el informe para los organizadores).

A continuación presentaremos el tipo de informe diseñado para los organizadores.

El número de asistentes evaluados fue de 371 alumnos, cuyas características sociodemográficas se analizaron en el estudio. En la tabla 1 aparecen las medias obtenidas por el total de cursos en los criterios evaluados: Organización, Impacto, alcance y difusión, Actividades, Beneficios, Contenidos, Metodología, Compañeros, Formador y Satisfacción general. Estos resultados corresponden a la evaluación de un sólo ítem, al que los asistentes debían responder en la última sesión. Esta gráfica se acompañó de una tabla en la que aparecían, en datos cuantitativos, las medias y las desviaciones típicas.

En la tabla 2 se presentan las distribuciones de respuestas en cada una de las puntuaciones de la escala (desde 1 hasta 6) para los criterios referentes a la Escuela en general: Organización, Impacto, alcance y difusión de la Escuela, Actividades, Beneficios y Satisfacción general. Estos datos se mostraron también en forma de tabla.

La tabla 3 muestra las distribución de respuestas para los restantes criterios relacionados con los cursos de formación: Contenidos, Metodología, Compañeros y Formador. Esta gráfica se acompañó también de una tabla en la que aparecían los datos cuantitativos.

Los criterios que se han evaluado mediante un procedimiento cualitativo fueron la Organización, el Impacto, Alcance y difusión de la Escuela, los beneficios aportados y las Actividades. En cada uno de estos criterios se ha distinguido entre aspectos positivos y negativos.

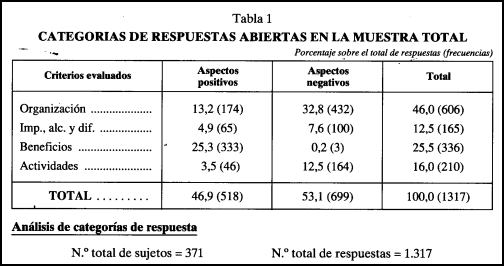

La Tabla 1 representa el número de respuestas, entre paréntesis, en cada criterio y según sean aspectos positivos o negativos, así como el porcentaje de respuesta que representa cada apartado en función del número total de respuestas (N = 1.317).

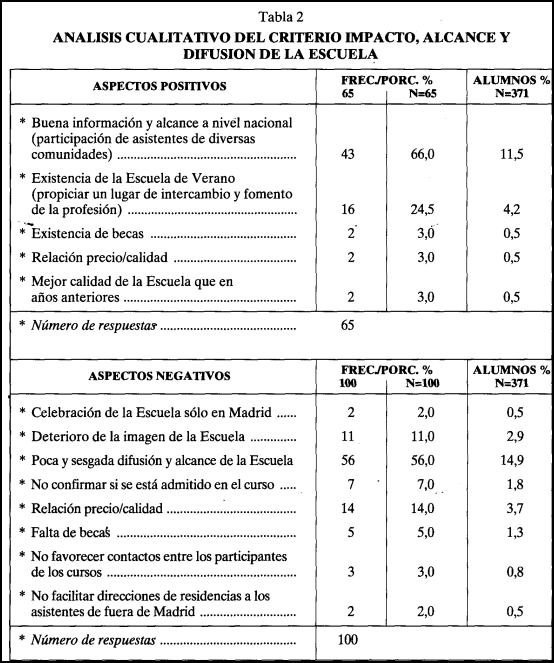

A continuación se detallaron las categorías de respuesta que surgieron del análisis para cada criterio evaluado y en función de los aspectos positivos y negativos. En la Tabla 2 puede verse un ejemplo del criterio Impacto, alcance y difusión de la Escuela. Cada categoría se acompaña de los siguientes datos: en la primera columna aparecen las frecuencias de respuestas que forman parte de esa categoría; en la segunda columna se incluye el porcentaje de respuesta que representa cada categoría en función del número de respuestas positivas o negativas de cada criterio, y en la tercera columna aparece el porcentaje de alumnos que se refiere a esa categoría de respuesta en función del número total de sujetos elevados.

Tras el análisis de las categorías de respuesta aparece en la Gráfica 4 la distribución de respuestas positivas y negativas en función del número total de respuestas para cada uno de los criterios; esta gráfica se acompañó de su correspondiente tabla con los datos cuantitativos.

Tras analizar los resultados globales se pasó al análisis de los resultados emitidos curso por curso. En primer lugar se analizaron las características sociodemográficas de cada curso. Seguidamente se confeccionaron otras gráficas y tablas donde se recogieron los resultados medios obtenidos por los 20 cursos en cada uno de los criterios. En las gráficas aparecía en forma de barra el resultado medio obtenido por los distintos cursos en cada criterio, y en las tablas se presentaron las medias y las desviaciones típicas.

Este mismo análisis se efectuó en función de las áreas establecidas: Salud, Educación, Servicios Sociales, Trabajo, Jurídica y Deporte, y en función del horario mañana/tarde, siguiendo los anteriores pasos.

Por último, se analizaron los resultados obtenidos en la muestra total de profesores. En primer lugar se presentaron las características sociodemográficas de la muestra total de profesores evaluados. A continuación se confeccionó una tabla en la que aparecían las medias y desviaciones típicas obtenidas por el total de formadores en cada uno de los criterios evaluados, y en forma de gráfica se representaron las medias obtenidas

Como complemento a los datos, se realizó una representación gráfica de la distribución de respuestas, en porcentajes, en las puntuaciones de la escala (desde 1 hasta 6) para cada uno de los criterios evaluados. Y a continuación se incluyeron estos resultados en forma de tabla.

Los resultados del análisis cualitativo en la muestra total de profesores se hizo de igual manera que para la muestra total de alumnos, sólo que en este caso los criterios fueron distintos.

A lo largo de estas páginas hemos presentado lo que puede ser un ejemplo de cómo realizar la valoración de un curso de formación, es decir, la evaluación de la reacción de los participantes a cursos de formación. Este sería una de los criterios de evaluación de la formación según Kirkpatrick (1987). El diseño de los instrumentos de medida, para evaluar los distintos criterios planteados, se llevó a cabo intentando cumplir los siguientes objetivos: que el diseño de los instrumentos de medida fuera de tal manera que recogiera la información necesaria y significativa para evaluar los criterios planteado; que el tiempo que tardaran los participantes y los formadores en cumplimentar los instrumentos fuera el mínimo posible, para no interferir en exceso el desarrollo de las sesiones del curso, y que la evaluación implicara la mínima dificultad para participantes y formadores. Para ello, se crearon unos instrumentos que no guardan el diseño tradicional de preguntas cerradas. La novedad de este procedimiento de valoración consiste en obtener no sólo datos cuantitativos sino también cualitativos, el diseño del instrumento de medida para recoger las opiniones de los sujetos, lo que a su vez perfila el diseño del informe de los resultados obtenidos; y la obtención de la información sesión a sesión. Todo ello ha proporcionado no sólo cumplir los objetivos, que nos planteamos sino obtener una rica y extensa información sobre la valoración de cursos de formación.

No obstante, la valoración de los cursos de formación es sólo uno de los criterios que propone Kirkpatrick (1987) para la evaluación de la eficacia de los cursos de formación. Tal como hasta ahora se vienen organizando y diseñando en las escuelas de verano del COP sólo nos fue posible evaluar dicho criterio. Sin embargo, sería de gran utilidad e interés plantear en futuras escuelas una evaluación global de la eficacia de los cursos de formación. Esto supondría un desarrollo paralelo entre la planificación, diseño y desarrollo de la escuela de verano y la planificación, diseño y desarrollo de la evaluación. En este sentido, algunas de las propuestas serían:

1. Efectuar un análisis de las necesidades de formación que bien pudiera hacerse a través de un sistema de encuestas a los colegiados.

2. Desarrollar un programa de formación en función de las demandas de los colegiados, de tal manera que los cursos que se ofrecieran se insertaran en categorías o áreas de necesidades de formación.

3. Establecer una medida «pre» de los conocimientos de los participantes a cada curso de formación.

4. Evaluar las reacciones de los participantes a cada curso sesión a sesión y una evaluación global del curso y de la organización de la escuela. En este punto creemos que nuestra experiencia ha sido útil y provechosa.

Establecer una medida «post» de los conocimientos adquiridos por los participantes en cada curso. Tanto en la medida «pre» como en la medida «post», los evaluadores podrían realizar una labor de conjunto con los formadores.

6. Y, por último, hacer un seguimiento de los participantes con objeto de evaluar la conducta y los resultados obtenidos con los cursos de formación.