Evaluaciû°n de la Calidad de Estudios de MetaanûÀlisis sobre la Eficacia de las Intervenciones en Revistas EspaûÝolas de PsicologûÙa

[Evaluation of the quality of studies in meta-analysis of intervention effectiveness in Spanish psychology journals]

Hilda Gambara1, Juan I. Durán2 y Álvaro Santana1

1Universidad Autû°noma de Madrid (UAM), EspaûÝa; 2Universidad a Distancia de Madrid (UDIMA), EspaûÝa

https://doi.org/10.5093/clysa2021a4

Recibido a 6 de Mayo de 2020, Aceptado a 23 de Septiembre de 2020

Resumen

En este trabajo se revisa la evaluación de la calidad de los estudios primarios incluidos en los metaanálisis publicados en las principales revistas españolas de psicología. Concretamente se analiza la codificación y evaluación de la calidad de los estudios en metaanálisis sobre eficacia de intervenciones, así como el propósito de esta evaluación y la relación entre la calidad y tamaños del efecto. Se encuentra que el 79% de los metaanálisis analizados incluyeron una evaluación de la calidad. Se discute la relación entre la menor calidad de los estudios en los metaanálisis y los resultados con mayores tamaños del efecto. Finalmente, se enfatiza la necesidad de mejorar el informe de los metaanálisis aportando evidencias de gran calidad.

Abstract

In this paper, we reviewed primary study quality assessments in meta-analyses published in the main Spanish psychology journals. Specifically, we analyzed whether the coding and evaluation of the quality of the primary studies in meta-analysis based on the efficacy of interventions is a common practice. The purpose of this evaluation is also to report the relationship between quality and the reported results (effect sizes). It is found that 79% of the meta-analyses analyzed included a quality assessment. The relationship between the lowest quality of studies included in meta-analyses and larger effect sizes is also discussed. Finally, we stress the need to improve the reporting of meta-analyses including high-quality evidence.

Palabras clave

Calidad de los estudios primarios, MetaanûÀlisis, Revistas espaûÝolas de psicologûÙaKeywords

Primary study quality, Meta-analysis, Spanish psychology journalsPara citar este artûÙculo: Gambara, H., Durán, J. I. y Santana, Á. (2021). Evaluaciû°n de la Calidad de Estudios de MetaanûÀlisis sobre la Eficacia de las Intervenciones en Revistas EspaûÝolas de PsicologûÙa. ClûÙnica y Salud, 32(3), 95 - 102. https://doi.org/10.5093/clysa2021a4

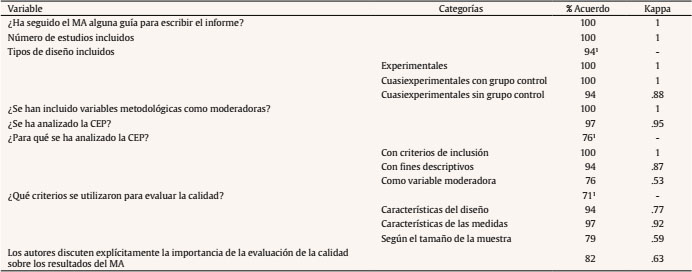

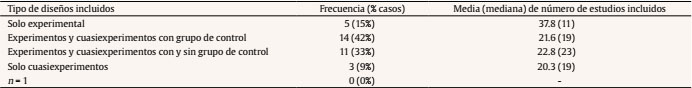

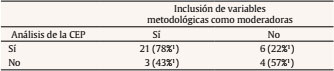

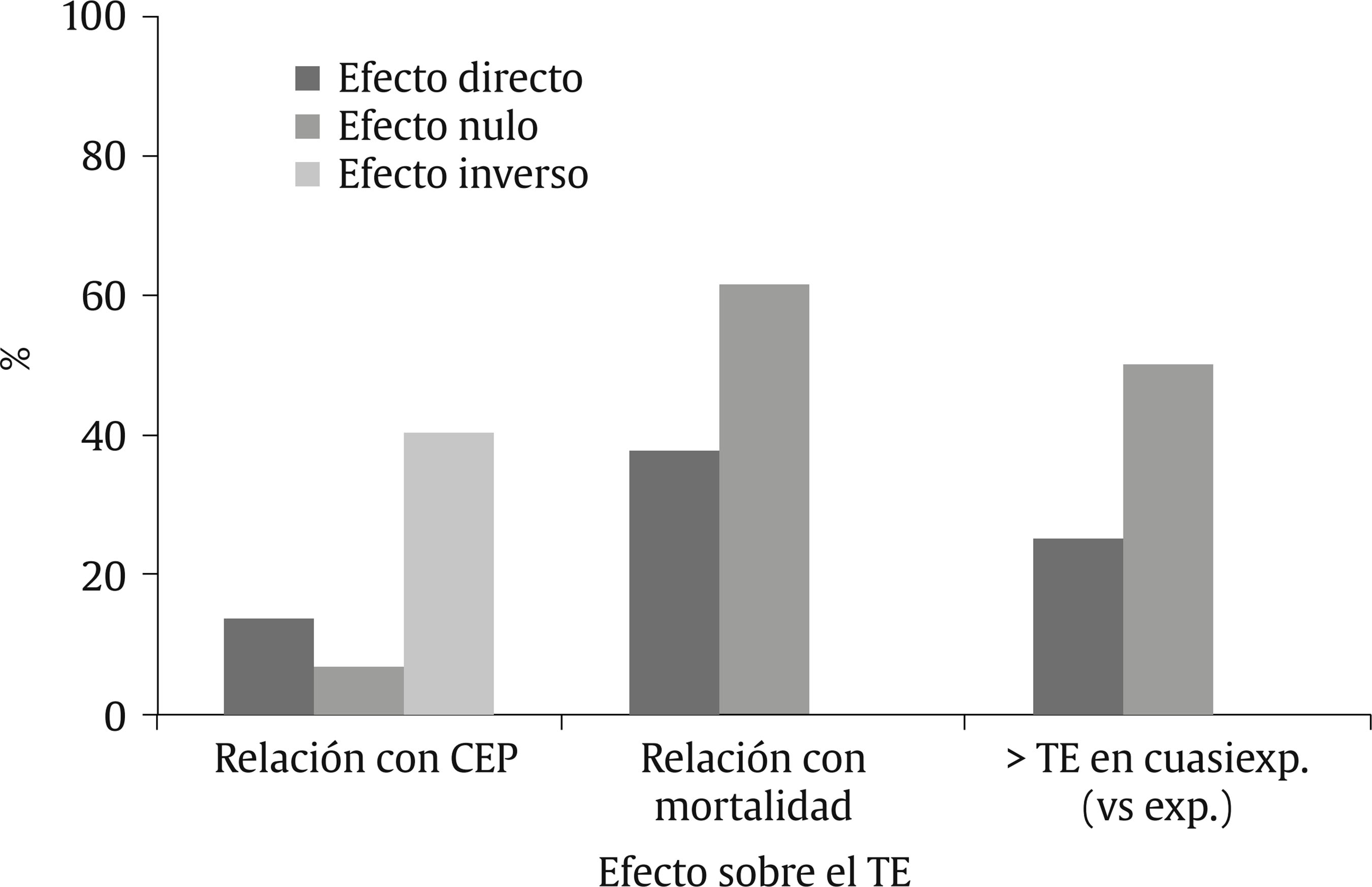

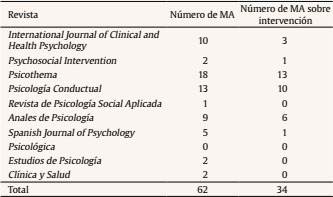

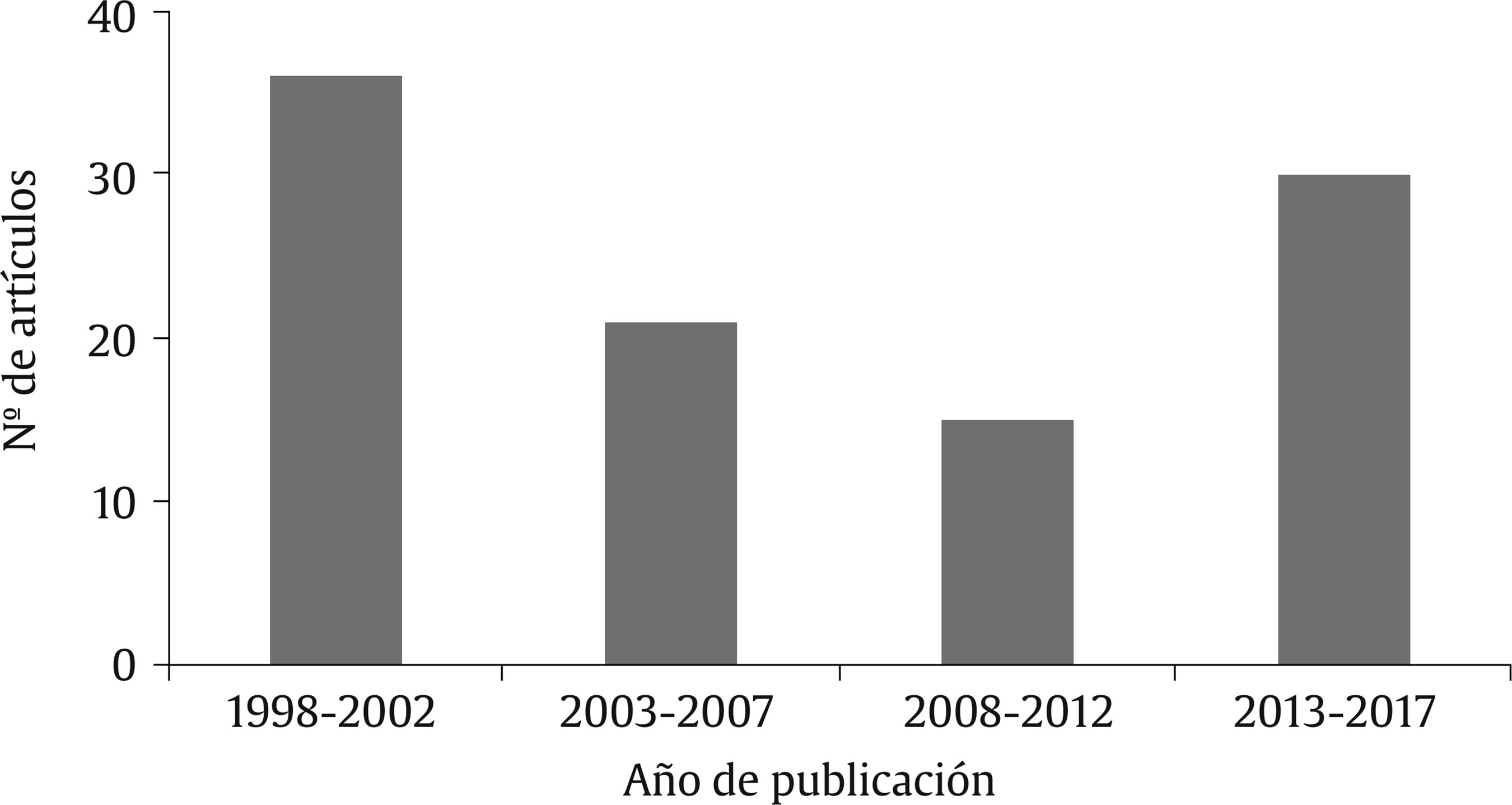

hilda.gambara@uam.es Correspondencia: hilda.gambara@uam.es (H. Gambara).Una de las primeras críticas que recibió el metaanálisis (MA) es la conocida como “garbage in, garbage out”, que implica la imposibilidad de realizar buenas síntesis a partir de trabajos de escasa calidad (Botella y Sánchez-Meca, 2015). Desde entonces es patente la preocupación por realizar MA donde se ponga de manifiesto de forma transparente el tipo de estudios que se integran, preocupación compartida por una práctica basada en la evidencia. Sin embargo, en Psicología la evaluación de la calidad metodológica de la investigación solo se ha incorporado recientemente (Protogerou y Hagger, 2019). No existe un criterio único para evaluar la calidad de los estudios primarios (CEP). Entre ellos encontramos el estatus de la publicación, la calidad del informe, el tipo de diseño según una jerarquía, las características de los mismos o el riesgo de sesgo (RS) (Wells y Littell, 2009). Aunque en las últimas décadas se ha desarrollado un número creciente de indicadores de dicha calidad, las revisiones sobre el tema han puesto de manifiesto limitaciones tanto en su construcción como en su uso (Chacón-Moscoso et al., 2016; Deeks et al., 2003; Wells y Little, 2002), constatándose resultados divergentes dependiendo de las herramientas utilizadas. En consecuencia, las conclusiones de algunos MA pueden depender del procedimiento de evaluación seguido (Herbison et al., 2006; Juni et al., 1999; Losilla et al., 2018). Lo que estos problemas están reflejando es que no existe una concepción única de la CEP (Johnson et al., 2015). Nosotros nos adscribimos a la definición de Valentine (2009), para quien la calidad es: “the fit between a study’s goals and the study’s design and implementation characteristics” (p. 130), definición que enlaza con la propuesta sobre la validez como aproximación a la veracidad de las inferencias sobre la relación entre variables, no como algo dicotómico o unidimensional, de todo o nada, sino como algo gradual (e.g., Shadish et al., 2002). Características diversas del diseño de un estudio y su implementación conducirán a inferencias que serán más o menos válidas en una o más dimensiones. En el contexto de este artículo, la validez más vinculada a la calidad es la validez interna. Ahora bien, esta es una propiedad más de las inferencias que del diseño en sí. Dado que no hay un único método que asegure la validez interna de las inferencias causales, en cada circunstancia habrá que valorar en qué medida cada método implica mayores o menores garantías en este sentido. Desde la medicina basada en la evidencia (MBE) se considera que la mejor evidencia es aquella derivada de los diseños experimentales de grupos aleatorios (ensayos controlados aleatorizados). En esta línea, la colaboración Cochrane y Campbell aconseja realizar MA con la mejor evidencia (utilizando el diseño como criterio de inclusión en la revisión) y analizar la CEP a partir del riesgo de sesgo (RS). Sin embargo, en el ámbito de la Psicología no es tan claro que en un mismo MA no deban incluirse estudios no estrictamente experimentales por considerarlos de menor calidad. Como plantea Valentine (2009), al menos no hay evidencia de que esto tenga que ser así; habrá que considerar el contexto de investigación, el tipo de diseño que se haya utilizado para alcanzar los objetivos y lo cuidadoso que se haya sido en el control de las amenazas a la validez. Por otra parte, en Psicología es usual que los MA incluyan estudios con metodologías no tan homogéneas como en Medicina (e.g., únicamente de grupos aleatorios), siendo más frecuente el uso de diseños cuasiexperimentales para evaluar intervenciones. A pesar del auge de esta línea de investigación, existen pocos estudios que hayan analizado la relación de la CEP con los MA en Psicología. Hohn et al (2018) han analizado dicha relación recientemente con una muestra de 386 MA, encontrando que en menos de un tercio se informaba explícitamente sobre la evaluación de la calidad, de los cuales aproximadamente la mitad (54.7%) describieron el procedimiento seguido explícitamente. Se constató también una gran heterogeneidad entre los instrumentos de evaluación. Estos resultados sugieren que informar sobre los estándares de calidad no es una práctica que haya penetrado en Psicología. El objetivo general de esta revisión es evaluar el papel de la CEP en los MA publicados en las principales revistas españolas. Una foto que evalúe la calidad de las fuentes puede contribuir a mejorar la credibilidad sobre las evidencias detectando los posibles problemas a resolver. Nos centramos en los MA sobre eficacia de intervenciones. Hohn et al. (2018) encontraron que es en estos donde más se reporta la calidad (un 55.2% en MA de eficacia de intervenciones frente a un 20.1% en MA de no intervenciones). Específicamente, en este trabajo se analiza si la evaluación de la CEP en MA sobre eficacia de intervenciones publicados en revistas españolas es una práctica común, la relación entre la calidad metodológica de los estudios y los TE estimados y, finalmente, los fines de dicha evaluación. Selección y Muestra de Estudios En primer lugar, se seleccionaron las principales revistas españolas a través del índice de impacto (Journal of Citations Reports, JCR, 2017) y el índice H de Google. A saber: Psicothema, International Journal of Clinical and Health Psychology, Anales de Psicología, Psicología Conductual, Revista de Psicología Social, Infancia y Aprendizaje, Spanish Journal of Psychology, Psicológica, Estudios de Psicología, Clínica y Salud y Psychosocial Intervention. En segundo lugar, se realizó una búsqueda (abril, 2019; sin límite temporal) de los MA utilizando las bases de datos PsycINFO y SCOPUS (a través del portal EBSCOhost), con las palabras clave en título y/o resumen: Meta-analysis o metaanálisis, Systematic Review o Revisión Sistemática, filtrando por el nombre de las revistas. Se obtuvieron 62 MA candidatos (Tabla 1). A través del título, resumen, y/o texto completo se depuraron las duplicaciones, los artículos teóricos, revisiones narrativas, resúmenes y los MA que no eran de eficacia de programas de intervención o tratamientos1. Se incluyeron todos los MA de eficacia de intervenciones independientemente del tipo de diseño utilizado en los estudios primarios. Se realizó, por último, una revisión manual de los números de las revistas que por antigüedad no constaban en SCOPUS host. La muestra final la constituyeron 34 MA. Tabla 2 Porcentaje de acuerdo interjueces e índice kappa de Cohen para las variables y categorías codificadas   Nota. 1Variables en las que era posible seleccionar más de una categoría. Los casos en los que hubo un acuerdo parcial (i.e., había acuerdo sobre algunas categorías, pero no en todas) se consideraron como desacuerdos en el cálculo del porcentaje de acuerdo global. Tabla 3 Porcentaje de metaanálisis en los que se incluye cada tipo de diseño (se incluyan o no otros también)   Se incluyeron todos los MA de eficacia de intervenciones independientemente del tipo de diseño utilizado en los estudios primarios. Se realizó, por último, una revisión manual de los números de las revistas que por antigüedad no constaban en SCOPUS host. La muestra final la constituyeron 34 MA. Codificación de Estudios Se elaboró un libro de codificación con categorías relativas a la CEP (procedimiento de evaluación, finalidad y repercusiones sobre los resultados). Se codificó revista, año de publicación, área de intervención, uso de guías estandarizada (MARS, PRISMA, etc.), tipo de diseño, variables metodológicas consideradas como moderadoras, explicitación del análisis de la CEP y finalidad del análisis de la calidad sobre el MA. Se codificaron también las relaciones explicitadas entre distintos aspectos de la calidad y los TE. Todos los estudios fueron codificados independientemente por el segundo y tercer autor. Los desacuerdos se discutieron y aclararon entre los tres autores. El acuerdo interjueces varió entre el 71% y el 100% (detalles de los acuerdos en Tabla 2). Análisis de Datos Tras la codificación se obtuvieron los porcentajes de acuerdo y el índice kappa de Cohen para cada una de las variables codificadas. En el caso de las variables en las que era posible seleccionar más de una categoría, los casos en los que hubo un acuerdo parcial (i.e., había acuerdo sobre algunas categorías, pero no en todas) se consideraron como desacuerdos. Una vez aclarados los desacuerdos, se obtuvieron estadísticos descriptivos a partir de la base de datos definitiva con el software de análisis estadístico SPSS v23.0. En concreto, los estadísticos fueron frecuencias absolutas y relativas correspondientes a las distintas categorías de cada variable y tablas de contingencia con frecuencias conjuntas absolutas y relativas para las distintas combinaciones de pares de variables. Es de destacar que de los 34 MA un 59% pertenecen a un mismo grupo de investigación, por lo que estas revisiones guardan características comunes. El período en el que más MA se publicaron es el comprendido entre 1998 y 2002 (Figura 1). Esto se debe principalmente a que la revista Psicología Conductual publicó un monográfico en 2002 dirigido por el grupo de investigación mencionado que representa un 18% de la muestra. Sobre el ámbito de estudio de los MA revisados, la mayoría van dirigidos a valorar la eficacia de programas de intervención o tratamientos de problemas de salud o psicológicos: ansiedad, fobia (7), enuresis, depresión, depresión infantil, TOC, insomnio, consumo de drogas, adicción al tabaco (2), maltrato (2), maltratadores. Una minoría se centra en programas de prevención, mientras que otra minoría se centra en la eficacia de intervenciones en lectura, escritura y comprensión. En el 91% de las revisiones no se explicitó si se seguía alguna guía estandarizada. Tres MA, todos publicados después del 2016, utilizaron la guía de informe estandarizada PRISMA. Ninguno hizo mención a las guías de la APA ni a ninguna otra guía. La mediana de estudios incluidos en los MA es de 19. En cuanto a los diseños de los estudios, solo cinco MA (15%) incluyeron exclusivamente diseños experimentales. Lo más frecuente (42%) fue combinar diseños de grupos aleatorios con cuasiexperimentales con grupo de control, aunque también encontramos casos en los que se incluyeron, además de los anteriores, diseños sin grupo de control (33%). No se incluye ningún MA de n = 1 (Tabla 3).2 Respecto a estos resultados, es importante tener en cuenta que en ocasiones no queda claro cuál es el tipo de diseño incluido al que se refieren los autores del MA. Por ejemplo, en ocasiones se hace referencia a estudios pre-experimentales, que fueron valorados en este trabajo como equivalentes a un diseño pre-post con un solo grupo a falta de una referencia más clara. El 71% de los MA incluyen variables metodológicas como moderadoras. Tabla 4a Tabla de contingencias con frecuencias y porcentajes de fila con los metaanálisis que realizaron análisis de la CEP y/o incluyeron variables metodológicas como moderadoras   Prácticamente todos los MA vinculados al mismo grupo de investigación siguen a Lipsey y Wilson (2001), quienes aconsejan recoger información relativa a variables extrínsecas, externas y metodológicas. Dentro de las variables metodológicas se codifican variables relativas a aspectos relacionados con el diseño, como puede ser la aplicación de asignación aleatoria, la realización de medidas de seguimiento o el tipo de grupo de control empleado, siendo también común valorar aspectos como el porcentaje de mortandad experimental o el tamaño muestral. De entre los estudios que valoran la calidad de los estudios primarios, el 78% incluye también variables metodológicas como moderadoras (Tabla 4a).3 Tabla 4b Frecuencia y porcentajes de fila de metaanálisis que incluyeron variables metodológicas como moderadoras que realizaron análisis de la CEP y propósito de la codificación de la CEP por tipo de diseños incluidos   Centrándonos en la CEP, del total de MA analizados, 27 MA (79%) informaron llevar a cabo una evaluación de la calidad; de estos MA, 18 (67%) indicaron explícitamente como se llevó a cabo. Los criterios utilizados para evaluar la calidad fueron las características del diseño (88% de los casos), el tamaño muestral (56%) y las características de las medidas (26%). En un 9% de las ocasiones no se indicó. Por otra parte, tal y como aparece en la Tabla 4b, es más habitual realizar una evaluación de la CEP cuanto más restrictivos son los criterios de inclusión empleados sobre los diseños de esos estudios. Así, el 80% de los MA que incluyeron solo experimentos realizaron una evaluación sobre la calidad metodológica de los estudios. Este porcentaje es similar para los MA que combinaron estudios experimentales y cuasiexperimentales (86% y 82%, incluyendo estudios con y sin grupo de control, respectivamente). En los casos en los que solo se incluyen cuasiexperimentos, este porcentaje baja hasta un 67%. Figura 2 Porcentaje de casos en los que aparecieron los efectos más frecuentemente reportados entre las moderadoras metodológicas, de entre los estudios que las analizar.   La mayoría de los MA que comparten equipo utilizaron una escala ad hoc de 9 ítems. Estos ítems no se especifican siempre, de manera que no podemos asegurar que se trate de la misma escala o se haya adaptado al contexto del MA4. Ocho MA utilizan siete herramientas estandarizadas para evaluar la CEP (la escala Jadad, Maryland Scale of Scientific Rigor (2), escala de Estimación de la Calidad, herramienta del NHS Center for Reviews and Dissemination, Collaborative Outcome Data, Quality Assessment Tool for Quantitative Studies y Scottish Intercollegiate Guidelines Network). Sobre la relación entre CEP y resultados del MA, como se muestra en la Tabla 5 y Figura 2, de los 15 MA que analizaron la calidad como variable moderadora, en un 61% de ellos se encontró una relación inversa entre calidad y tamaño del efecto (TE) a nivel descriptivo, que en el 40% de los casos fue estadísticamente significativa. Sólo un MA (6.7%) reporta una relación directa entre la calidad y el TE; en el resto de casos no se encontró o no se reporta ningún tipo de relación. Tabla 5 Resultados del estudio de la repercusión de variables relacionadas con la CEP sobre la magnitud del TE   Atendiendo a otras variables metodológicas, se encontró una relación directa entre mortandad experimental y TE a nivel descriptivo en un 53% de los casos en los que se estudió y estadísticamente significativa en un 38%. Ningún MA reportó una relación inversa entre estas dos variables. Por último, también es frecuente encontrar un mayor TE en diseños cuasiexperimentales que en experimentos cuando se utilizó el diseño como variable moderadora (57% a nivel descriptivo y 25% con diferencia estadísticamente significativa). Sin embargo, un MA indica mayores TE en diseños experimentales que en cuasiexperimentales a nivel descriptivo y otro MA reporta este mismo efecto estadísticamente significativo. Contrasta el muy escaso uso de guías de informe estandarizadas en comparación con lo reportado en la literatura dentro del ámbito médico; este dato es consistente con el encontrado por Hohn et al. (2018) en el ámbito de la Psicología. Trabajos anteriores han examinado esta cuestión, concluyendo que en la mayoría de los MA los informes carecen de la información suficiente para ser replicados (e.g., Dieckmann et al., 2009; Harwell y Maeda, 2008). Seguir estas guías facilita el reporte de síntesis más transparentes, consistentes y replicables (Atkinson et al., 2015). En este trabajo hemos constatado una falta de adherencia a dichas guías; por ejemplo, en algunos casos no se incluyó el término metaanálisis en el propio título, aunque puede ser justificable por la antigüedad de los trabajos, algo que se debería tener en cuenta a la hora de realizar revisiones. La falta de utilización de estas guías puede deberse a un desconocimiento de las mismas, a que la publicación del MA sea previa a la creación de dichas guías y/o al seguimiento de otros manuales o recomendaciones publicadas por expertos en este tema en España. Si esto último es cierto, sugerimos incluir en la publicación las recomendaciones seguidas; de esta manera, el lector del MA (y los revisores) podrá evaluar mejor el MA. En algunas revistas internacionales se está recomendando cumplimentar una lista de chequeo estandarizada que se envía junto al informe MA para su publicación. Recientemente, Rubio-Aparicio et al. (2018) han publicado recomendaciones para el reporte del MA. La APA en su séptima edición abunda en este aspecto. También en el siguiente enlace del grupo Equator puede encontrarse una amplia guía de informes (más del ámbito médico y de la salud) para diferentes estudios primarios y MA (https://www.equator-network.org/reporting-guidelines/) que no solo pueden mejorar el informe, sino que pueden ayudar a la realización de la propia investigación. En relación al ámbito de intervención, los MA analizados se relacionan mayoritariamente con la eficacia de tratamientos clínicos y solo una minoría evalúa la eficacia de otro tipo de programas (e.g., de prevención). Sobre el tipo de diseños incluidos en los MA, aunque tanto la colaboración Cochrane como la Campbell aconsejan realizar síntesis homogeneizando el tipo de diseño, hay autores que abren la posibilidad a incluir diseños heterogéneos (e.g., experimentales y cuasiexperimentales) pero analizando el RS (la validez interna) y agregando solo aquellos con mayor calidad (Sterne et. al, 2016; Wilson y Lipsey, 2006). Esta situación está más cercana a las investigaciones sobre eficacia de programas o tratamientos psicológicos, donde se constata que habitualmente se aplican diseños experimentales y cuasiexperimentales. Restringir el tipo de diseño en el contexto de la evaluación de la eficacia de programas o de tratamientos psicológicos limitaría en gran medida las evidencias que nos pueden aportar diferentes estudios realizados con rigor metodológico (Codray y Murphy, 2009). El resultado encontrado sobre las principales características metodológicas de los estudios primarios es consistente con Hohn et al. (2018). Estas son el diseño y la pérdida de participantes. Por otro lado, más de la mitad (67%) de los MA que valoran la calidad explicitan cómo se analiza, porcentaje superior al 55% reportado por Hohn et al. (2018). Habría que analizar qué ocurre con respecto a los MA de no intervención en un futuro trabajo. Centrándonos en los problemas de las escalas de calidad, en los artículos revisados se reflejan los problemas documentados en la literatura. Por ejemplo, en algunas de las escalas utilizadas se puntúa si hay asignación aleatoria para, a continuación, codificar si el diseño es experimental o cuasiexperimental. Está claro que existe un solapamiento de información, puesto que si el diseño es experimental necesariamente habrá asignación aleatoria o se evalúa la pérdida de participantes, pero no se diferencia de la pérdida no aleatoria de participantes, amenaza a la validez interna que puede ser mayor. Así, reflejar en un solo número aspectos que no tienen por qué estar relacionados, como medidas de validez de los resultados y procedimiento de asignación de los participantes, es una fuente de inconsistencia (Valentine y Cooper, 2008). Nos podríamos encontrar dos estudios con la misma puntación en calidad, uno con una validez interna débil y otro con una fuerte validez de medida. En definitiva, revisadas las escalas utilizadas en los MA de este trabajo, en línea con la colaboración Cochrane y Cambpell, no parece recomendable su utilización, al menos sin explicitar los ítems que se incluyen en dicha escala. Hohn et al. (2018) plantearon las siguientes explicaciones sobre la escasa evaluación de la CEP en Psicología: a) no es un hábito en este ámbito, b) sí se considera para la inclusión de los estudios, pero no se explicitan las herramientas utilizadas, c) no se sabe qué procedimiento o herramienta escoger de entre todas las existentes (estos autores reportaron 34 herramientas en los 69 MA que aplicaron alguna). En nuestro caso, esta variabilidad ha sido bastante menor. Sobre la finalidad de esta evaluación, en ningún caso se utilizó como criterio de ponderación o para un análisis de sensibilidad (Lispsey y Wilson, 2001). En la mayoría de los MA se analizó empíricamente la calidad del estudio como potencial variable moderadora de las estimaciones de los TE. El término riesgo de sesgo solo aparece en un MA. Hay que tener en cuenta que este término apareció en 2006 y no se incluyó en el manual de la APA del 2010; sí es recogido por Appelbaum et al. (2018) e incorporado en la séptima edición APA (2020), por lo que seguramente este término se irá extendiendo. Por último, planteamos la siguiente cuestión que habría que constatar empíricamente y que sería coherente con algunos resultados que han suscitado la crisis de replicabilidad. Puesto que con el trascurso del tiempo se ha ido incidiendo cada vez más en la importancia de incluir evidencias de calidad en los MA, cabe pensar que los MA más cercanos en el tiempo incorporan estudios cualitativamente mejores, lo que podría repercutir sobre las conclusiones de las revisiones; podría ocurrir que los TE promedio fuesen menores ahora que en MA anteriores, que podrían estar sobreestimando TE. En cualquier caso, siguiendo a Botella y Durán (2019), creemos que el progreso de la ciencia implica cambiar desde una perspectiva competitiva a otra cooperativa. La idea de que cada estudio de investigación contribuye a la ciencia, no por su aportación singular o revolucionaria, algo que ocurre excepcionalmente, sino porque junto con otros colabora para alcanzar resultados consistentes, nos impulsa no solo a desarrollar investigaciones de calidad sino a informar de las investigaciones pensando en su aportación. El cuidado que debe ponerse en los informes no se convierte en una cuestión formal o estética, sino que puede ser imprescindible para que un trabajo concreto pueda ser incorporado o no en una futura revisión sistemática. En consecuencia, la CEP y la calidad del informe deberían ir de la mano. The interest concerning the assessment of primary study quality (PSQ) comes from areas such as meta-analysis (MA) and Evidence-Based Medicine (EBM). Since reports need to include high quality studies in order to make good syntheses, the concern about doing MAs which explicitly report the type of studies included in them is increasing. Nevertheless, there is no unique criterion for the mentioned quality assessment yet. Some of these criteria are, for example, publication status, quality of the report or type of design, amongst others. Research has shown limitations in the construction of scales for evaluating PSQ. As a consequence, results might differ depending on the scale used, as well as the conclusions drawn from MAs using them. We follow Valentine (2009), who defines quality as “the fit between a study’s goals and the study’s design and implementation characteristics” (p. 130). Design characteristics lead to inferences with different validity in one or more dimensions. But there is no single method to ensure internal validity (i.e., the kind of validity which is more closely related to quality) and we should evaluate the extent to which we can guarantee it in every circumstance. From the EBM perspective, randomized controlled trials (RCTs) provide the best evidence, and both the Cochrane and Campbell collaborations recommend to make syntheses using this type of design. However, in Psychology and other related areas it would not be adequate to include solely RCTs in the reviews since the use of other designs (e.g., quasi-experiments) is widespread and plenty of evidence would be disregarded. Recently, Hohn et al. (2018) evaluated the report of the primary study quality (PSQ) in a sample of 386 MAs in Psychology. They found that less than a third of the syntheses reported PSQ, and only half of the studies which reported it explicitly described the procedure. Therefore, that study shows the low use of quality reports in MAs performed in Psychology. As a result, the general objective of this work is the evaluation of PSQ reports published in the main Spanish journals in a sample of MAs whose aim is to summarize evidence about the efficacy of interventions or treatments. Thus, we pretend to detect whether PSQ assessments in Spanish MAs is a common practice, if it is explicitly reported or not, what its purposes are, and whether there is a relationship between the PSQ and the effect sizes (ES). We evaluated only intervention studies because Hohn et al. (2018) found that the highest percentage of PSQ assessments were performed in that area. Method Eleven journals were selected according to their Journal of Citation Reports (JCR, 2017) impact factor, namely: Psicothema, International Journal of Clinical and Health Psychology, Anales de Psicología, Psicología Conductual, Revista de Psicología Social, Infancia y Aprendizaje, Spanish Journal of Psychology, Psicológica, Estudios de Psicología, Clínica y Salud, and Psychosocial Intervention. A search of the MA was carried out (April, 2019) in PsycINFO and Scopus, using meta-análisis [and metaanálisis], meta-analysis, revisión sistemática, and systematic review as keywords. Sixty two MAs were obtained at first (Table 1). Through title, abstract and/or full text, we dropped out duplications, theoretical articles, and other MAs which did not evaluate the efficacy of interventions or treatments. The final sample was integrated by 34 MAs, which included primary studies with different types of designs. A coding manual was elaborated to register: journal, year of publication, area of intervention, use of standardized guidelines (MARS, PRISMA, etc.), type of design of the primary studies included, methodological variables considered as moderators variables, explanation of the PSQ analysis and purpose of the quality analysis in MAs. Finally, the relationships found between quality and ES were coded. The second and third author of this work independently coded all these aspects, with an interrater agreement ranging from 71% to 100%. Results Most MAs in the sample evaluated health or psychological intervention programs concerning issues such as anxiety, depression, enuresis, OCD, and others. To a lesser extent, they summarized the effect of prevention programs or efficacy of interventions in reading, writing, and comprehension. Ninety one percent of MAs did not explicitly follow any reporting guide. Only three of them used PRISMA, but none of them referenced APA or other guidelines. Regarding the types of design included, 42% of the reviews combined randomized controlled trials and quasi- experiments, 33% included designs with no control group and 15% included only experimental designs. Seventy one percent of MAs included methodological variables, such as type of design, randomization, follow-up measures, type of control group used, experimental mortality, or sample size as moderator variables. Seventy eight percent of MAs that assessed PSQ included these methodological variables as moderators. Seventy nine percent of the reviews reported having carried out a PSQ assessment. Eighteen (67%) of these indicated explicitly how it was performed. The most employed criteria to assess quality were: design characteristics (88%), sample size (56%), and characteristics of measures (26%). Table 4b shows that MAs that employ more restrictive inclusion criteria carried out a PSQ evaluation in a greater proportion. Eighty percent of MAs which incorporated solely experimental designs carried out this evaluation, while 67% of the syntheses which included entirely quasi-experimental designs did. Eight MAs use up to 7 scales to assess PSQ, including the Jadad Scale, Maryland Scale of Scientific Rigor, and others. Table 5 illustrates that 61% of MAs which incorporated PSQ as a moderating variable found an inverse relationship between PSQ and ES at a descriptive level, and 40% found a statistically significant relationship. Most of the remaining reviews did not show or report any relationship between these two variables, and only one of them mentioned a direct relationship regarding PSQ and ES. Furthermore, a direct relationship between experimental mortality (or attrition) and ES was found in 53% of MAs in a descriptive way, and in 38% of the entire sample of MAs the relationship was found statistically significant. Another variable that influences effect sizes is the type of design, since 57% of reviews registered a greater effect in quasi- experiments rather than experiments at a descriptive level, and 25% found this difference to be statistically significant. Discussion In accordance with the findings of Hohn et al. (2018), there is a low use of standardized reporting guidelines in the field of Psychology with respect to other areas. Previous studies have pointed out the lack of information that many reports have, a fact that makes it difficult to replicate these syntheses (Dieckmann et al., 2009; Harwell & Maeda, 2008). This replication is necessary for more transparent, consistent, and replicable progress in science. The scarce use of these guidelines may be due to a lack of knowledge, an adherence to other references or to the guides being subsequently created with respect to the oldest investigations. Following Rubio-Aparicio et al. (2018), we recommend citing the guidelines followed in future MAs, since they allow a faster and more effective evaluation of the reports. The following link contains different reporting guides for meta-analysts: https://www.equator-network.org/reporting-guidelines/. As some authors pointed out, the inclusion of heterogeneous designs in the same MA might be desirable in Psychology, especially in areas related to psychosocial, educational or psychological treatment programs, where experimental designs are not frequently performed. By including only a certain type of design, the amount of evidence provided by other methodologically rigorous studies would be restricted (Codray & Murphy, 2009). According to the findings reported in Hohn et al. (2018), the type design and the loss of participants are the methodological characteristics most taken into account. Furthermore, in our sample, 67% of MAs which analyzed the quality explained how it was done. This percentage is higher than the 55% reported by Hohn et. al. (2018). The problems related to quality scales are not only referred to their scarce use, but also to their construction. For example, there is an overlap of information when including items about random assignment and also about experimental or quasi-experimental design, since experimental designs necessarily have a random assignment of the participants to the different conditions of the study. Therefore, there may be two studies with differing internal validity and measurement validity with the same score on a quality scale. Some of these evaluations cannot distinguish between issues which have little in common, like validity measures of the results and the method used to assign the participants to the conditions. Therefore, since a unidimensional approach of quality seems simplistic, it does not seem appropriate to use these scales without clearly explaining the items that constitute them. According to Hohn et. al. (2018), the scarce evaluation of PSQ in Psychology can be explained by a) a lack of habit, b) quality is considered as an inclusion criterion but the assessment tools used are not reported, c) lack of agreement amongst all the options available. In our review, we did not find as much variability in the use of different tools as these authors reported, probably because our sample was smaller. The majority of MAs used PSQ as a moderating variable in the estimation of ES, but none of them used it as a weighting criterion or for performing a sensitivity analysis. It is conceivable that primary studies with higher quality are increasingly incorporated in the closest MAs in time. This may impact the conclusions of the reviews. To this end, a research question, which is beyond the aim of this study, is whether ES could be lower now compared to older meta-analytical studies, according to the inverse nature of the relationship between methodological quality and ES found in some reviews. Finally, we follow Botella and Durán (2019) in emphasizing the cooperative perspective necessary for the progress of science. Furthermore, we recommend reporting research in a consistent and systematic way, following standardized guidelines for performing MA, as this may impact the incorporation of such investigations in a future review and it can make them more accessible and replicable for other colleagues. In other words, measuring PSQ could be useless if it is not followed by an appropriate report, and vice versa. Conflicto de Intereses Los autores de este artículo declaran que no tienen ningún conflicto de intereses. Notas 1 No se puso ningún tipo de restricción en cuanto a la temática del tipo de intervención o programa prevención (salud, educativo o social). 2 La suma de 33 estudios aquí en lugar de los 34 seleccionados se debe a que en uno de ellos (Méndez et al., 2002) menciona que los estudios incluidos fueron “diseños de grupo que comparen un grupo de tratamiento frente a uno de control o tratamiento alternativo” y aunque probablemente se trate de cuasiexperimentos, al no saberse con seguridad no fue incluido en ninguna de las categorías que se muestran en la tabla, por lo que no aparece representado en ella. 3 Los tres estudios que no analizan la CEP fueron los siguientes: Beelman y Lösel (2006), que analizaron como moderadora el tamaño muestral, el tipo de medida del resultado (post y/o seguimiento) y el tiempo entre la intervención y última medida de la VD; el trabajo de Mendez et al. (2002), que tiene como variables moderadoras la vía de reclutamiento y tipo de grupo control; Redondo et al. (2002), que tuvieron en cuenta el diseño aleatorio (si/no), las bajas y el período hasta medida de seguimiento. 4 Como ejemplo de estas escalas, una ellas es una escala de 9 ítems [0-9] en la que se codifican los siguientes ítems: 1) asignación aleatoria de los participantes (sí = 1; no, con control de variables confundentes = 0.5 y no, sin control de variables confundentes = 0); 2) tipo de diseño (cuasiexperimental = 0.5; experimental = 1); 3) tamaño muestral del grupo tratado en el post-test ([n < 6] = 0, [6 < n < 9] = 0.5, [n > 10] = 1); 4) pérdida de sujetos del grupo tratado en el postest (igual o mayor del 30% = 0, menor del 30% = 0.5, no hubo mortandad = 1); 5) seguimiento (menor de 6 meses = 1, entre 6 y 11 meses = 0.5, 12 o más meses = 1); 6) mediciones de la misma variable dependiente en el pretest y postest (0, 0.5, 1); 7) Calidad de los instrumentos de evaluación; 8) Uniformidad en el tratamiento (no = 0, sí = 1); 9) Ceguera de los evaluadores y de los participantes (0 = no existe ciego, 0.5 = simple ciego, 1 = doble ciego). Para citar este artículo: Gambara, H., Durán, J. I. y Santana, A. (2021). Evaluación de la calidad de estudios de metaanálisis sobre la eficacia de las intervenciones en revistas españolas de psicología. Clínica y Salud, 32(3),95-102. https://doi.org/10.5093/clysa2021a4 Referencias Las referencias señaladas con asterisco pertenecen a estudios de metaanálisis. |

Para citar este artûÙculo: Gambara, H., Durán, J. I. y Santana, Á. (2021). Evaluaciû°n de la Calidad de Estudios de MetaanûÀlisis sobre la Eficacia de las Intervenciones en Revistas EspaûÝolas de PsicologûÙa. ClûÙnica y Salud, 32(3), 95 - 102. https://doi.org/10.5093/clysa2021a4

hilda.gambara@uam.es Correspondencia: hilda.gambara@uam.es (H. Gambara).Copyright © 2026. Colegio Oficial de la Psicología de Madrid

e-PUB

e-PUB CrossRef

CrossRef JATS

JATS